Kiến trúc Blackwell mới của NVIDIA ghi dấu ấn mạnh mẽ tại MLPerf Training v5.0 với hiệu suất vượt trội trên tất cả các bài kiểm tra, khẳng định vị thế dẫn đầu trong cuộc đua huấn luyện AI thế hệ mới.

Theo đó, NVIDIA tiếp tục khẳng định vị thế dẫn đầu trong lĩnh vực AI khi kiến trúc Blackwell mới của hãng đạt hiệu năng vượt trội trong vòng đánh giá MLPerf Training gần đây nhất — lần thứ 12 kể từ khi chuẩn đánh giá này ra mắt vào năm 2018.

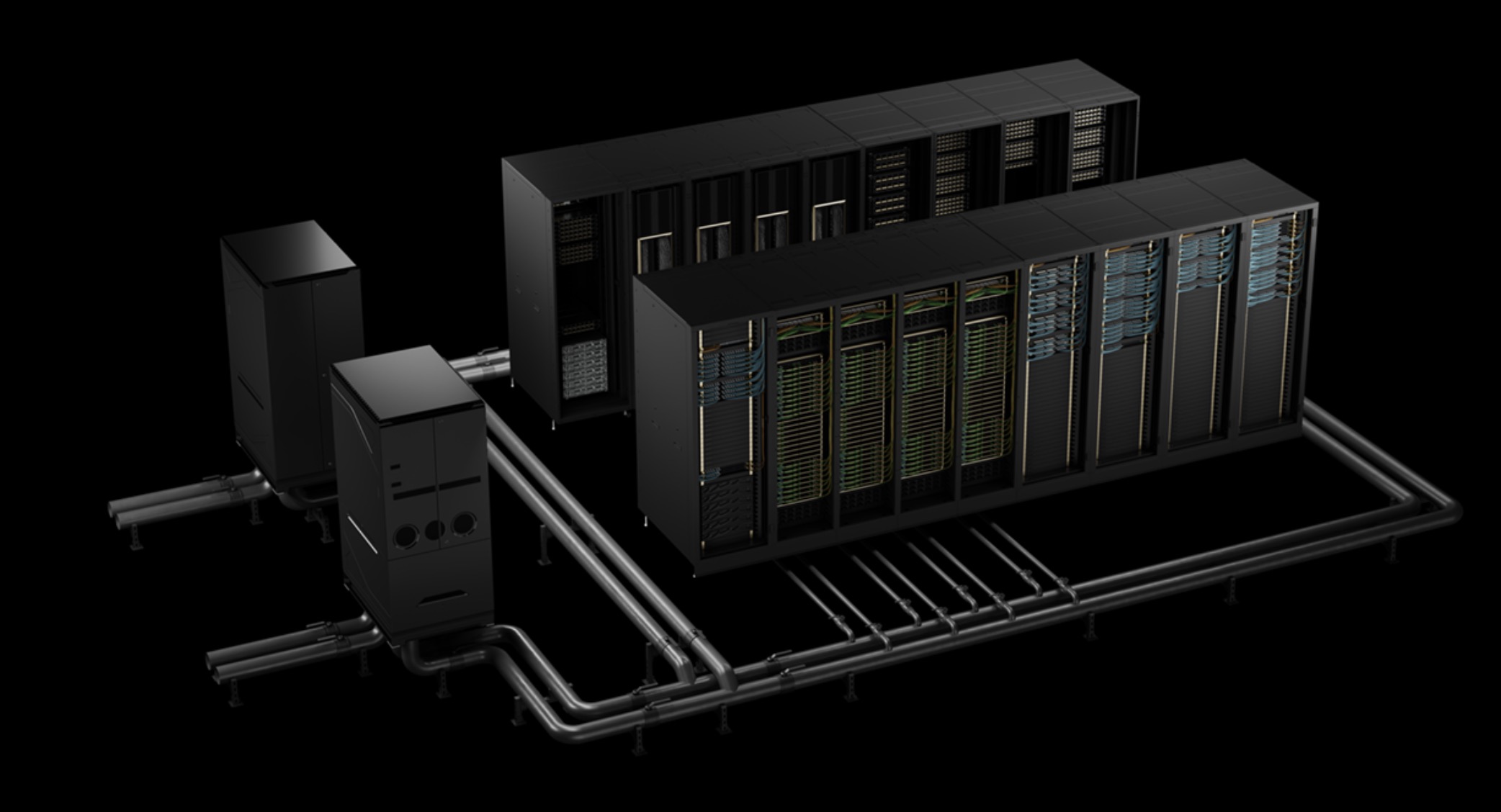

Trong bối cảnh nhu cầu đào tạo và triển khai các mô hình AI ngày càng tăng cao, NVIDIA đang hợp tác với các doanh nghiệp toàn cầu để xây dựng “nhà máy AI” — trung tâm tính toán phục vụ thế hệ ứng dụng AI mới. Kiến trúc Blackwell được thiết kế riêng để đáp ứng những yêu cầu khắt khe của các ứng dụng này, cả về huấn luyện lẫn suy luận.

Trong vòng MLPerf Training v5.0, nền tảng AI của NVIDIA là nền tảng duy nhất tham gia đầy đủ tất cả các bài kiểm tra, bao gồm cả bài đánh giá khó nhất tập trung vào huấn luyện mô hình ngôn ngữ lớn (LLM): Llama 3.1 với 405 tỷ tham số. Kết quả cho thấy NVIDIA dẫn đầu về hiệu năng quy mô lớn trên mọi hạng mục — từ LLM, hệ thống gợi ý, mô hình đa phương thức, phát hiện đối tượng đến mạng nơ-ron đồ thị (GNN).

Các bài kiểm tra quy mô lớn lần này sử dụng hai siêu máy tính AI tích hợp nền tảng Blackwell: hệ thống Tyche xây dựng trên GB200 NVL72 và hệ thống Nyx sử dụng nền tảng DGX B200. Ngoài ra, NVIDIA còn phối hợp cùng CoreWeave và IBM để thực hiện các bài thử nghiệm với tổng cộng 2.496 GPU Blackwell và 1.248 CPU Grace của NVIDIA.

Cụ thể, ở bài đánh giá Llama 3.1 405B pretraining, kiến trúc Blackwell đạt hiệu suất cao hơn 2,2 lần so với thế hệ trước ở cùng quy mô hệ thống. Trong khi đó, bài kiểm tra tinh chỉnh Llama 2 70B với phương pháp LoRA trên hệ thống DGX B200 (sử dụng 8 GPU Blackwell) đạt hiệu năng gấp 2,5 lần so với kết quả từ số lượng GPU tương đương của vòng trước.

Những bước tiến này có được nhờ vào loạt công nghệ tiên tiến tích hợp trong kiến trúc Blackwell, bao gồm: rack làm mát bằng chất lỏng mật độ cao, bộ nhớ hợp nhất 13,4TB mỗi rack, kết nối nội bộ thế hệ 5 NVIDIA NVLink và NVLink Switch, cùng mạng InfiniBand NVIDIA Quantum-2 phục vụ mở rộng quy mô hệ thống. Bên cạnh đó, phần mềm NeMo Framework của NVIDIA cũng góp phần tối ưu hóa việc huấn luyện các mô hình LLM đa phương thức thế hệ mới — tiền đề cho việc triển khai AI tác tử (agentic AI) trong tương lai gần.

AI tác tử được kỳ vọng sẽ là động cơ thúc đẩy nền kinh tế AI thế hệ mới. Những ứng dụng này không chỉ tạo ra các token giá trị mà còn mang lại thông tin có thể ứng dụng rộng khắp trong mọi ngành nghề và lĩnh vực nghiên cứu.

Nền tảng trung tâm dữ liệu của NVIDIA hiện tích hợp đầy đủ GPU, CPU, hệ thống mạng tốc độ cao và thư viện phần mềm đa dạng như CUDA-X, NeMo Framework, TensorRT-LLM và NVIDIA Dynamo. Sự kết hợp đồng bộ này cho phép các tổ chức rút ngắn đáng kể thời gian huấn luyện và triển khai mô hình, từ đó gia tăng tốc độ tạo giá trị thực tế.

Hệ sinh thái đối tác của NVIDIA cũng tham gia tích cực vào vòng MLPerf lần này. Bên cạnh CoreWeave và IBM, còn có sự góp mặt của các tên tuổi lớn như ASUS, Cisco, Dell Technologies, Giga Computing, Google Cloud, Hewlett Packard Enterprise, Lambda, Lenovo, Nebius, Oracle Cloud Infrastructure, Quanta Cloud Technology và Supermicro.

Để biết thêm thông tin chi tiết về các tiêu chuẩn đánh giá MLPerf, bạn có thể truy cập trang chính thức của tổ chức MLCommons.